自動運転車の”目”となる特殊センサー達 (note)

今回はDeep4Drive@モビリティ×AI『note』より 川西発之 / 陳発暉さんの記事からご寄稿いただきました。

自動運転車の”目”となる特殊センサー達 (note)

自動運転のナカミ【周辺認識編】

この記事の目的

事故や渋滞が無くなる!運送業が効率化する!時間が節約できる!…という明るい話から、事故の責任は誰が負うの?車がハッキングされたら?AIとかロボットに運転任せるの怖い…という心配になる話まで、色々な議論がされている自動運転技術。しかしそう言った自動運転が来る来ないという議論を盛んにしている一方、自動運転がどのようにして動いているのかなどと言った中身の深いところまで詳しい方は少ないのではないでしょうか。私はというと、数年前にこの技術を知って以来すぐに進路を変え自動運転研究室に入ったり、研究室入る前から有料オンライン講座*1 (計約30万円…汗)で学んだりと、この業界のキャッチアップに勤しんできました。そこでこの記事を通して自動運転技術の中身を噛み砕いて紹介することで、より一層深い議論ができたり、この産業に張るか張らないかを考えて頂けたらなと思います。

本記事では、【仕組み編】*2 で出て来た 1. 周辺認識 の技術についてもう少し掘り下げて行こうと思います。周りの状況を正確に捉えるのが目的なため、人間に例えると”目”の役割ですね。

*1:「Become a Self-Driving Car Engineer」『UDACITY』

https://www.udacity.com/course/self-driving-car-engineer-nanodegree–nd013

*2:「自動運転は全部で3つの工程に分けられる ~認識、判断、制御~」2019年7月11日『note』

https://note.mu/deepracerno1/n/n2358ab55c8f0

1. 周辺認識 ← 今ココ

2. 状況判断

3. 車体制御

カメラ

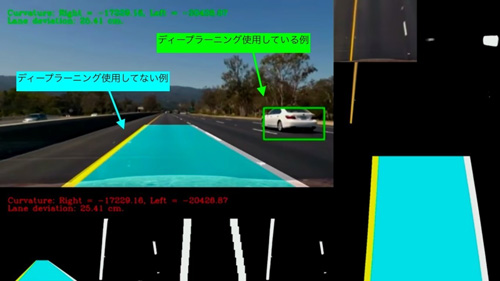

近年ディープラーニングなどと言った機械学習の目覚ましい発展で注目されている画像処理技術は、もちろん自動運転の周辺認識にも使用されています。しかし確かにディープラーニング×画像処理の相性が抜群に良いからと言って、全部が全部AIを使った画像処理という訳ではありません。

この例で言うと、画像や動画の中に映ってるのが”車両”なのか”歩行者”なのかや、何の標識かを判断するのにはディープラーニングがよく用いられますが(黄緑)、単に「白線はどこか」を検出するためにはディープラーニングを使用していません(水色)。

ディープラーニングによる物体の識別の仕組みは、コンピューターに何千枚、何万枚もの車の画像を見せて「これは車だ」と教え込んでコンピューターに覚えさせることです。んでたまにテストして、コンピューターが間違った答えを言ったらもう一周教え込んでそしたら次はちょっと精度良くなって……の繰り返しです。故に大量の”車画像データ”が必要なんですよね、教え込むために。

白線の方はどうやって検出しているかと言うと、例えば画像の白線が映ってるはずのエリア(車両前方~画像消失点までの三角形)以外の部分はトリミングして → 画像の色を白黒画像とかに変換して → 白い点々の集まりを見つけてそれらを頼りに白線を予測する……と言ったように画像を数学的に変換しまくってるんです。故に大量の”白線画像データ”をコンピューターに学習させる必要はなく、1枚の画像からでも「ここが白線だ」と検出することは可能です。

LIDAR(ライダー)

LIDARはよく見るあの自動運転車の頭上でクルクル回ってるやつです。

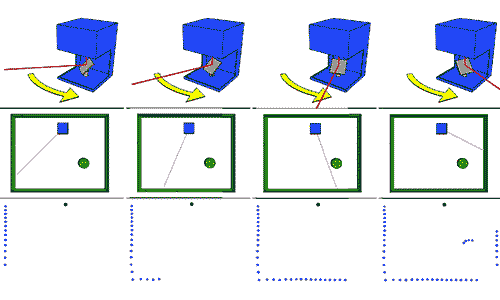

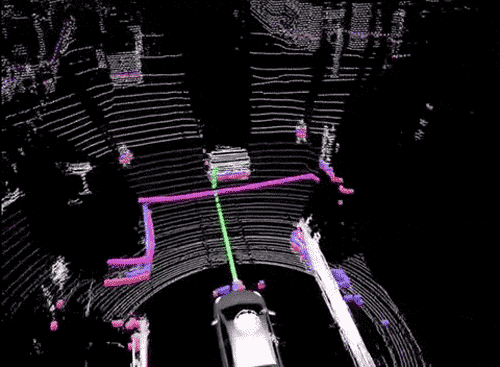

LIDARは目に見えないレーザー光を出して、(何か障害物に当たって)跳ね返ってくるまでの時間差を計測してその障害物までの距離を測定します。こう言った何かビームを当ててその跳ね返りを計測する手法を反響定位法と呼び、目の見えないコウモリが超音波を出して洞窟内の距離感測ってるのと同じ原理です。LIDARはクルクル回らせて周囲360°の情報を集めてきます。

引用元

「いまさら聞けないライダー(Lidar)入門」2017年2月13日『TechCrunch Japan』

https://jp.techcrunch.com/2017/02/13/20170212wtf-is-lidar/

ついでにその障害物がどんだけ強くレーザー光を反射したかという反射率もわかるので、障害物の材質もある程度わかります。それを応用すれば道路のアスファルトと白線の塗料は反射率が違うので、道路上のどこが白線なのかまでもわかります(カメラで白線検出した情報と擦り合わせます)。つまりもっとLIDARの精度が上がれば、歩行者が髪の毛フサフサなのかハゲ頭なのかまでわかっちゃうのかもしれません笑。

360° 回してるので同心円状の輪っか模様が映るのも特徴

しかしデメリットもあり、それは(ちょっと考えれば当たり前に思えるのですが)カメラと違って凹凸のない物の内容までは読み取れません。進入禁止の標識も30km制限の標識も、両方とも「ただの丸い板が数メートル先にある」としか認識されません。また、雨や雪に弱いです。それと値段がクソ高いので一般向けの乗用車に搭載させるのには抵抗があります。

RADAR(レーダー)

これは海上の戦艦や空の戦闘機を見つけるあのレーダーと一緒です。映画などに出てくる「敵のレーダーに引っかからないようにステルス機で行くぞ!」のあのレーダーです。計測の仕組みは、LIDARがレーザー光の反射だったのに対して、RADARは電波の反射を計測して障害物を検知します。電波は金属に反応しやすいので、車両の検出にぴったしなんですよね。

超音波は近くの物を検出するのに向いているに対し、電波は遠くまで飛ぶので、よく車両の前方に取り付けられます。しかし遠くへよく飛ぶ代わりに小さな物体を見つけたりするのは苦手なので、LIDARとは違って周辺の物体が何であるかというよりも、RADARはいち早くそこに物体が存在するかということを知る目的で使用されます。なのでLIDARのようにクルクル回さずに、前方エリアを見張る(前から突っ込んでくる何かしらの塊がいないか見張る)ために車両の前方に設置されるのです。

他にもTeslaが採用している超音波センサーなどもあります。超音波は先ほど少し触れたように計測できる距離が短いので、走行中というよりも例えば駐車といった作業時に本領発揮します。

Tesla Model S の超音波センサーが埋め込まれてる箇所

今回は自動運転の”目”の役割である、周辺認識に使われてるセンサー類について深掘りしました。それでは次回は【状況判断編】を書こうと思います。

「自動運転車はどうやって現在地を把握してるのか? GPSだけじゃない」2019年7月11日『note』

https://note.mu/deepracerno1/n/ncb61b7e3ea47

文:川西発之 / 陳発暉

プロフィール:Deep4Drive開発メンバー。高専情報科(C/C++)→大学機械科→HWエンジニアインターン at ドローンベンチャー(Python)→SWエンジニアインターン in NY(PHP)→ニートしながらアプリ開発(React Native)→大学院で自動運転の研究(C++)。日本生まれの純血中国人

執筆: この記事はDeep4Drive@モビリティ×AI『note』より 川西発之 / 陳発暉さんの記事からご寄稿いただきました。

寄稿いただいた記事は2019年7月16日時点のものです。

ガジェット通信はデジタルガジェット情報・ライフスタイル提案等を提供するウェブ媒体です。シリアスさを排除し、ジョークを交えながら肩の力を抜いて楽しんでいただけるやわらかニュースサイトを目指しています。 こちらのアカウントから記事の寄稿依頼をさせていただいております。

TwitterID: getnews_kiko

- ガジェット通信編集部への情報提供はこちら

- 記事内の筆者見解は明示のない限りガジェット通信を代表するものではありません。